목차

- 신경망 기초

- 퍼셉트론

- 다층 퍼셉스론(Multi Layer Perceptron)

- 학습 방법의 종류

신경망 기초

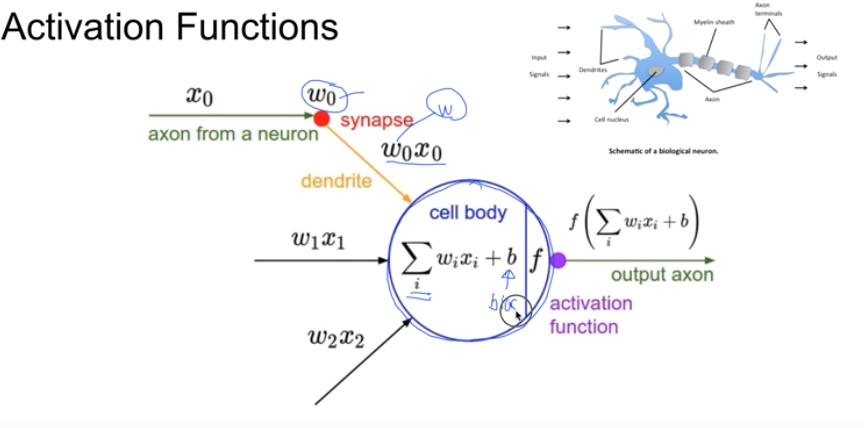

Activation Functions

- cell Body∑𝑖𝑛𝑊𝑖𝑥𝑖+𝑏∑inWixi+b

신경망의 원리 예 : 위의 cell Body 이 어떤 값을 넘으면 1, 넘지 않으면 0 으로 output

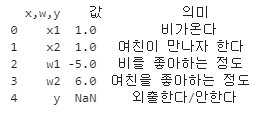

아래의 DataFrame의 구체적인 예시

- y = 1X(-5) + 1X6 = 1

- bias 난 태생적으로 비가 싫어 가중치 = -2

- y = 1 - 2 y값이 -1 이므로 0보다 작으므로 ,외출 안함

Gate뉴런들

And, or, Nand 는 생략

XOR Gate

- XOR 게이트는 단층 퍼셉트론으로는 만들수 없다. OR 과 NAND를 이용

- AND(OR(x1,x2), NAND(x1,x2))

import pandas as pd

import numpy as np

a = {'x,w,y' : ['x1','x2','w1','w2','y'],

'값' : [1,1,-5,6,None],

'의미' : ['비가온다','여친이 만나자 한다','비를 좋아하는 정도','여친을 좋아하는 정도','외출한다/안한다']}

print(pd.DataFrame(a,columns =['x,w,y', '값', '의미']))

딥러닝에서 자주 사용하는 활성화 함수

- SIgmoid𝜎(𝑥)=11+𝑒−(𝑥)σ(x)=11+e−(x)시그모이드는 많이 다루었기 때문에 생략 0또는 1 값으로 출력

- tanh

![]()

SIgmoid 의 대체제로 사용될 수 있는 활성화 함수.

출력 범위가 -1 에서 1사이

기본 미분 공식 http://taewan.kim/post/tanh_diff/ tanh 미분공식

- ReLU

![]()

- ReLu는 0보다 작을때는 0을 사용한다.

- 0보다 큰 값에 대해서는 해당값을 그대로 사용한다.

'공부 > AI School 인공지능 여름캠프' 카테고리의 다른 글

| 딥러닝 ANN(Artificial Neural Network), 손실함수, 역전파법 (0) | 2021.05.03 |

|---|---|

| 딥러닝 텐서플로우 소개 및 기본 사용법 - [AI School] (0) | 2021.05.03 |

| 머신러닝 의사결정트리(Decision Tree), 앙상블, 엔트로피 - [AI School] (1) | 2021.05.03 |

| 머신러닝 분류 Classification - [AI School] (0) | 2021.05.03 |

| 머신러닝 회귀(Regression) 정리 - [AI School] (0) | 2021.05.03 |

목차

- 신경망 기초

- 퍼셉트론

- 다층 퍼셉스론(Multi Layer Perceptron)

- 학습 방법의 종류

신경망 기초

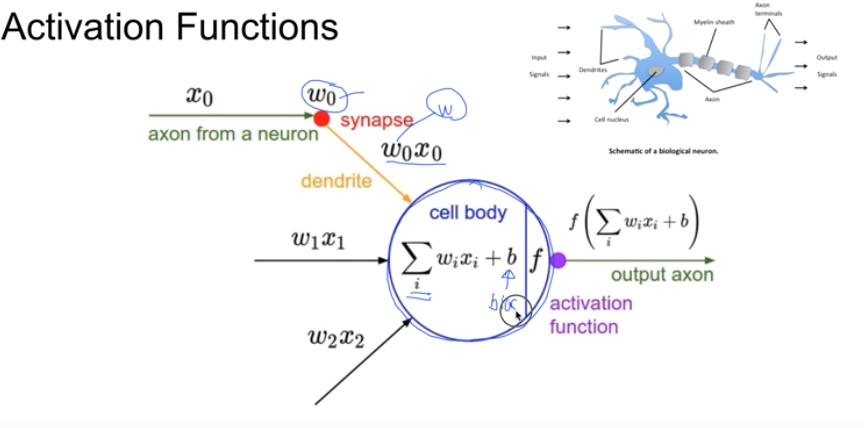

Activation Functions

- cell Body∑𝑖𝑛𝑊𝑖𝑥𝑖+𝑏∑inWixi+b

신경망의 원리 예 : 위의 cell Body 이 어떤 값을 넘으면 1, 넘지 않으면 0 으로 output

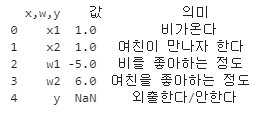

아래의 DataFrame의 구체적인 예시

- y = 1X(-5) + 1X6 = 1

- bias 난 태생적으로 비가 싫어 가중치 = -2

- y = 1 - 2 y값이 -1 이므로 0보다 작으므로 ,외출 안함

Gate뉴런들

And, or, Nand 는 생략

XOR Gate

- XOR 게이트는 단층 퍼셉트론으로는 만들수 없다. OR 과 NAND를 이용

- AND(OR(x1,x2), NAND(x1,x2))

import pandas as pd

import numpy as np

a = {'x,w,y' : ['x1','x2','w1','w2','y'],

'값' : [1,1,-5,6,None],

'의미' : ['비가온다','여친이 만나자 한다','비를 좋아하는 정도','여친을 좋아하는 정도','외출한다/안한다']}

print(pd.DataFrame(a,columns =['x,w,y', '값', '의미']))

딥러닝에서 자주 사용하는 활성화 함수

- SIgmoid𝜎(𝑥)=11+𝑒−(𝑥)σ(x)=11+e−(x)시그모이드는 많이 다루었기 때문에 생략 0또는 1 값으로 출력

- tanh

![]()

SIgmoid 의 대체제로 사용될 수 있는 활성화 함수.

출력 범위가 -1 에서 1사이

기본 미분 공식 http://taewan.kim/post/tanh_diff/ tanh 미분공식

- ReLU

![]()

- ReLu는 0보다 작을때는 0을 사용한다.

- 0보다 큰 값에 대해서는 해당값을 그대로 사용한다.

'공부 > AI School 인공지능 여름캠프' 카테고리의 다른 글

| 딥러닝 ANN(Artificial Neural Network), 손실함수, 역전파법 (0) | 2021.05.03 |

|---|---|

| 딥러닝 텐서플로우 소개 및 기본 사용법 - [AI School] (0) | 2021.05.03 |

| 머신러닝 의사결정트리(Decision Tree), 앙상블, 엔트로피 - [AI School] (1) | 2021.05.03 |

| 머신러닝 분류 Classification - [AI School] (0) | 2021.05.03 |

| 머신러닝 회귀(Regression) 정리 - [AI School] (0) | 2021.05.03 |